이 내용은 Sung kim님의 강의를 바탕으로 만들어졌습니다.

기본 개념

H(x) = Wx+b를 찾는 것이 목적

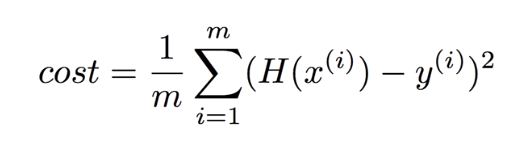

각 데이터(점)에 대해 (H(x)-y)^2의 총합이 가설 그래프와 실제 데이터와의 오차가 됨.

(x일 때 실제 값이 y이며, x일 때 모델이 예측한 값이 H(x)이다.)

이 오차를 cost라고 하며, 이것을 줄이는 것이 목적이다.

따라서 수학적으로 표현하면,

이며, 이 때 cost는 W와 b의 값에 따라 달라지기 때문에 cost(W,b)라고 한다.

그래서 W와 b를 줄이는 것이 목적이 된다.

'컴퓨터 > ML' 카테고리의 다른 글

| Jupyter Notebook 접속 오류(프록시) (0) | 2020.03.12 |

|---|---|

| docker에서 gpu 자원 활용하기(Nvidia) (0) | 2020.01.21 |

| [Tensorflow #3] Linear Regression (2) (0) | 2019.12.27 |

| [Tensorflow #1] 기본 개념 (0) | 2019.12.26 |